نقش دمای (Temperature) در مدلهای زبانی بزرگ: تعادل بین دقت و خلاقیت

در دنیای هوش مصنوعی، واژهی دمـا (Temperature) هیچ ربطی به گرما ندارد! این یک پارامتر مهم است که تعیین میکند پاسخ مدل زبانی تا چه حد خلاق یا قابل پیشبینی باشد. به زبان ساده، دما میزان تصادفیبودن پاسخ را کنترل میکند.

وقتی Temperature پایین است، مدل محتاط عمل میکند و معمولاً محتملترین کلمه را انتخاب میکند. اما هرچه Temperature بالاتر برود، مدل ریسکپذیرتر میشود و سراغ گزینههای غیرمنتظرهتر و گاهی خلاقانهتر میرود.

میتوان گفت دما مثل «دکمهی تنظیم خلاقیت» است:

دمای پایین یعنی پاسخهای منطقی، دقیق و قابل اعتماد؛

دمای بالا یعنی پاسخهای آزادتر، خلاقتر و گاهی شاعرانه!

برای مثال، اگر از ChatGPT بخواهید در دمای ۰.۸ لطیفهای بگوید، احتمالاً پاسخ جالب و خلاقی میشنوید. اما در دمای ۰.۱، ممکن است جوک آنقدر خشک و مکانیکی باشد که خندهتان نگیرد!

دما در مدلهای زبانی دقیقاً چیست؟

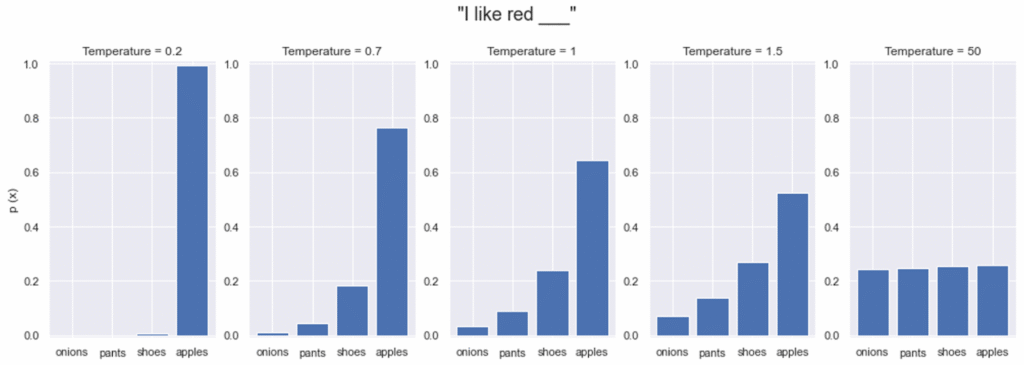

دمای مدل زبانی، پارامتری است که در فرآیند نمونهبرداری (sampling) هنگام تولید متن استفاده میشود. وقتی مدل قرار است کلمهی بعدی را انتخاب کند، فقط یک گزینهی محتمل ندارد، بلکه برای هر کلمهی ممکن، احتمالی اختصاص میدهد.

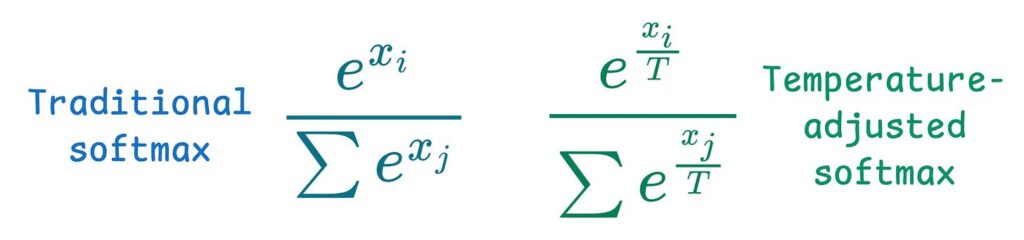

این احتمالات از روی مقادیری به نام logit محاسبه میشوند. مدل این مقادیر را با استفاده از تابعی به نام softmax به احتمال تبدیل میکند، و دما (T) همان عاملی است که این احتمالها را مقیاسبندی میکند.

به زبان ساده:

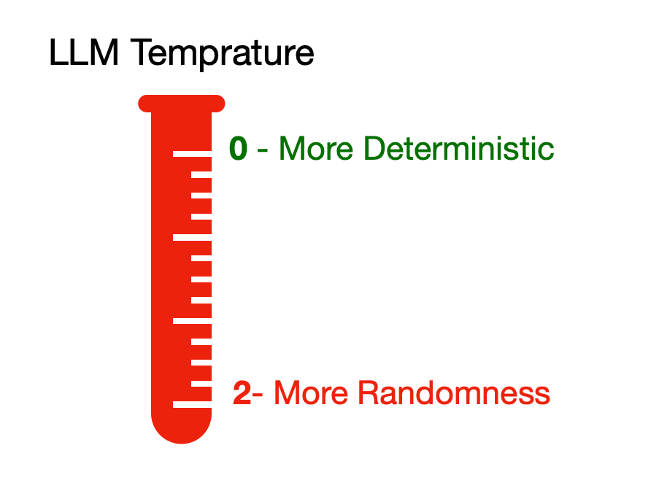

- T پایین (مثلاً ۰.۱): مدل با قطعیت بالایی عمل میکند و تقریباً همیشه محتملترین کلمه را انتخاب میکند. در نتیجه، خروجی دقیق و منظم است، اما گاهی خشک و تکراری بهنظر میرسد.

- T متوسط (حدود ۰.۵ تا ۰.۸): کمی تنوع به پاسخ اضافه میشود. مدل همچنان منطقی مینویسد، اما در عین حال لحن طبیعیتر و انسانیتری دارد.

- T بالا (بیش از ۱): مدل آزادانهتر رفتار میکند و احتمال انتخاب واژههای غیرمنتظره بیشتر میشود. این میتواند منجر به جملههایی خلاقانه و متفاوت شود ، هرچند گاهی هم از واقعیت دور یا بیربط به نظر برسد.

برای مثال:

- T = 0.1 : پاریس پایتخت فرانسه است.

- :T = 0.7 پاریس، قلب تپندهی فرانسه، سرزمین هنر و کروسان.

- T = 1.2 : پاریس در رؤیای عطر کروسان و شعر قدم میزند.

در نتیجه، دما تعیین میکند مدل مثل یک پژوهشگر دقیق رفتار کند یا مثل یک شاعر خیالپرداز.

علم پشت ماجرا

در هستهی محاسبات مدل، تابع Softmax وجود دارد. مدل برای هر واژهی ممکن، عددی به نام logit تولید میکند و سپس آنها را با دما مقیاسبندی میکند تا به احتمال تبدیل شوند:

در این فرمول،

- : (z_i )i امتیاز خام (logit) برای واژهی

- : (T) دما

🔹 وقتی T بالا میرود، اختلاف بین امتیازها کمتر میشود، و توزیع احتمال صافتر و تصادفیتر میگردد.

🔹 وقتی T پایین میآید، اختلافها بزرگتر میشوند، توزیع تیزتر میشود، و مدل تقریباً همیشه محتملترین گزینه را انتخاب میکند.

به بیان دیگر، دما مقدار آشوب یا عدم قطعیت (entropy) را در خروجی تنظیم میکند:

- دمای پایین → خروجی قطعی و پایدار

- دمای بالا → خروجی آزاد و خلاق

تأثیر دما بر خروجی

| دما | نمونهی خروجی | ویژگی و نتیجه |

| T = 0.1 | چای سبز نوعی چای است که از برگهای تازه بهدست میآید. | دقیق و بیخطا، اما خشک و کتابی |

| T = 0.7 | چای سبز نوشیدنی آرامشبخشی است که طعم ملایمی دارد و پر از آنتیاکسیدان است. | طبیعی و روان؛ متعادل میان دقت و تنوع |

| T = 1.2 | چای سبز مزهای از صبح زود و هوای بارانی دارد؛ تلخ و آرام مثل یک سکوت کوتاه. | خلاقانه و احساسی، گاهی دور از واقعیت |

| T = 2.0 | چای سبز با بخار خیال برمیخیزد و در فنجانش جنگل میرقصد. | بسیار آزاد و شاعرانه؛ جذاب ولی بیثبات و بیدقت |

افزایش دما یعنی افزایش خلاقیت، اما در مقابل کاهش دقت و انسجام. انتخاب مقدار مناسب بستگی دارد به هدف شما از تولید متن.

چه زمانی از دماهای مختلف استفاده کنیم؟

| بازهی دما | کاربرد | مزایا و معایب |

| 0-0.3 | کارهای دقیق و تکرارشونده مثل کدنویسی، خلاصهسازی، پاسخهای علمی | دقیق و پایدار؛ اما گاهی خشک |

| 0.5-0.8 | نوشتار طبیعی مثل پست وبلاگ یا مقاله | تعادل خوب بین دقت و خلاقیت |

| 0.9-1.5 | نوشتار خلاق مثل داستان، شعر، ایدهپردازی | نوآورانه، ولی ممکن است بینظم شود |

💡 هیچ دمای «درست» یا «بهترین» وجود ندارد. باید با آزمایش، محدودهی مناسب برای نیاز خودتان را پیدا کنید.

برداشتهای اشتباه رایج

- دما هوش مدل را بالا نمیبرد.

دمای بالا فقط احتمال انتخاب کلمات متفاوت را افزایش میدهد، نه منطق یا درک مدل را. - دما به احساسات مدل ربطی ندارد.

افزایش دما باعث نمیشود مدل «هیجانزده» یا «اعتمادبهنفسدار» شود؛ فقط احتمالها را تغییر میدهد. - دما روی حافظه یا فهم متن تأثیری ندارد.

دما فقط مرحلهی انتخاب کلمهی بعدی را کنترل میکند، نه درک کلی مدل از متن.

نکات کاربردی

✅ ترکیب دما با Top-p

دما دامنهی تنوع را تنظیم میکند، در حالی که top-p فقط پر احتمالترین گزینهها (مثلاً ۹۰٪) را نگه میدارد. ترکیب این دو کنترل دقیقتری روی خلاقیت و انسجام میدهد.

✅ آزمایش کنید!

با یک پرامپت ثابت، خروجی را در دماهای مختلف ببینید (مثلاً ۰.۲، ۰.۷، ۱.۲) تا تفاوت لحن و محتوا را تجربه کنید.

✅ قابل تنظیم در همهی APIها

در پلتفرمهایی مثل OpenAI، Hugging Face یا Cohere میتوانید دما را بهسادگی تغییر دهید. معمولاً مقدار پیشفرض حدود ۱ است.

💬 نکته: در پروژههای تولید محتوای واقعی، معمولاً از دماهای میانی (۰.۵ تا ۰.۷) استفاده میشود تا تعادل بین دقت و خلاقیت حفظ شود.

جمعبندی

دما یکی از سادهترین اما تأثیرگذارترین پارامترها در مدلهای زبانی است. با تغییر آن، میتوان خروجی را از متنی خشک و دقیق به متنی خلاق و آزاد تبدیل کرد.

نتیجه:

- دمای پایین → دقت و ثبات

- دمای متوسط → تعادل

- دمای بالا → خلاقیت و تنوع

هیچ مقدار ثابتی برای همهی کاربردها وجود ندارد ، بسته به هدف خود، میتوانید با تنظیم این پارامتر، لحن و شخصیت مدل را شکل دهید.