بیایید یک سناریوی ملموس را تصور کنیم: فرض کنید آلبرت اینشتین را به عنوان مدیر پشتیبانی شرکتتان استخدام کردهاید. او نابغه است، قدرت تحلیل بینظیری دارد و پیچیدهترین مسائل را حل میکند. اما در روز اول کاری، وقتی مشتری تماس میگیرد و میپرسد: «شرایط بازگشت کالا در جشنواره تابستانه امسال چیست؟»، اینشتین سکوت میکند.

چرا؟ آیا دانش او کافی نیست؟ ابداً! مشکل اینجاست که اینشتین هرچقدر هم نابغه باشد، اسناد داخلی شرکت شما را مطالعه نکرده است. او «دانش عمومی جهان» را دارد، اما از «دانش خصوصی و لحظهای سازمان» شما بیخبر است. مدلهای زبانی بزرگ (LLMs) دقیقاً در همین وضعیت هستند. آنها اینشتینهایی هستند که دانششان در زمان آموزش منجمد شده است. آنها نه قیمت لحظهای ارز را میدانند، نه ایمیلهای دیروز مدیرعامل را خواندهاند و نه دسترسی به دیتابیس SQL شما دارند.

راه حل چیست؟ باید سیستمی ایجاد کنیم که اسناد مورد نیاز را در لحظه جستجو کرده و در اختیار مدل قرار دهد. به این معماری، RAG (Retrieval-Augmented Generation) یا «تولید متن با کمک بازیابی» میگویند و آن مخزن اسناد حیاتی، همان پایگاه دانش است. در این مقاله، معماری این معماری را بررسی میکنیم تا هوش مصنوعی ما دیگر در پاسخ به سوالات تخصصی ناتوان نماند.

برای درک عمیق پایگاه دانش و چرایی نیاز به RAG، ابتدا باید بدانیم که «دانش» در مدلهای زبانی چگونه ذخیره و بازیابی میشود. درست مانند مغز انسان که دو نوع کارکرد حافظه دارد، هوش مصنوعی نیز از دو منبع متفاوت برای پاسخگویی استفاده میکند:

1.حافظه پارامتریک دانش درونی :

حافظه پارامتریک همان دانش فشرده و انتزاعی است که در قلب مدل و در میان میلیاردها پارامتر (Weights) آن ذخیره شده است. وقتی مدلهایی مثل GPT یا Llama آموزش میبینند، تمام کتابها و مقالاتی را که خواندهاند، حفظ نمیکنند؛ بلکه الگوها، روابط و ساختارها را یاد میگیرند.

- ویژگی کلیدی: این حافظه «درونی» است. یعنی فایل یا دیتابیسی جداگانه وجود ندارد.

- مزیت: سرعت بسیار بالا؛ مدل بلافاصله و بدون نیاز به جستجو پاسخ میدهد.

- نقطه ضعف بزرگ: این حافظه «منجمد» است. تغییر آن بسیار سخت و پرهزینه است نیاز به Fine-Tuning دارد.همچنین اگر سوالی نیازمند جزئیات بسیار دقیق باشد، مدل ممکن است به جای بازیابی واقعیت، شروع به بازسازی (حدس زدن) کند که منجر به توهم (Hallucination) میشود.

- مثال انسانی: مهارتهایی که ملکهی ذهن شما شدهاند، مثل دوچرخهسواری یا دستور زبان فارسی.

2. حافظه غیرپارامتریک دانش بیرونی :

این همان حافظهای است که RAG را ممکن میسازد. در اینجا، دانش در داخل مدل ذخیره نمیشود، بلکه در منابعی خارج از مدل مانند) وکتور دیتابیسها، فایلهای PDF یا ویکیپدیا(نگهداری میشود و مدل صرفاً به آنها دسترسی دارد.

- ویژگی کلیدی: این حافظه «بیرونی» و مبتنی بر اسناد واقعی است.

- مزیت: دقت فوقالعاده و بهروزرسانی آسان. همانطور که در تصویر زیر میبینید، برخلاف حافظه پارامتریک، در اینجا میتوانیم بهسادگی اطلاعات را اضافه (Add)، حذف (Delete) یا آپدیت کنیم، بدون اینکه نیاز باشد مغز مدل را جراحی (آموزش مجدد) کنیم.

- مکانیزم: برای استفاده از این حافظه، به یک سیستم جستجوگر (Retriever) نیاز داریم تا اطلاعات مرتبط را پیدا کند.

- مثال انسانی: کتابخانهای که به آن مراجعه میکنید یا جستجویی که در گوگل انجام میدهید. شما این اطلاعات را حفظ نیستید، اما میدانید کجا آنها را پیدا کنید.

RAG هنر ترکیب دو نیمکره

معماری RAG دقیقاً پل ارتباطی بین این دو نوع حافظه است.

- حافظه پارامتریک وظیفه «استدلال، فهم زبان و جملهسازی» را بر عهده دارد.

- حافظه غیرپارامتریک وظیفه «تأمین فکتها، آمار دقیق و دادههای سازمانی» را انجام میدهد.

در واقع، RAG به مدل اجازه میدهد تا برای استدلال از مغز خودش استفاده کند، اما برای بیان حقایق، به کتابچه راهنمای شما نگاه کند.

انواع معماری پایگاه دانش در سیستمهای RAG

پایگاه دانش (Knowledge Base) در سیستمهای RAG، صرفاً یک محل ذخیرهسازی نیست؛ بلکه هستهی مرکزی چرخه «بازیابی ← بازنمایی ← تولید پاسخ» است. بسته به اینکه «جنس» دادههای اختصاصی شما چیست و کاربران به دنبال چه نوع پاسخهایی هستند، سه معماری استاندارد برای مهندسی این بخش وجود دارد:

1. دادههای غیرساختاریافته (Unstructured Data)

این معماری رایجترین و شاید حیاتیترین بخش محسوب میشود، چرا که حجم عظیمی از دانش داخلی و تخصصی در قالب دادههای بدون ساختار و متنی نهفته است. از فایلهای PDF و قراردادها گرفته تا ایمیلها، چتهای کاری/تیمی و مقالات وبلاگ، همگی در این دسته قرار میگیرند.

مکانیزم عملکرد: در این معماری، ما یک خط لوله (Pipeline) مشخص داریم: ابتدا متون خام توسط استراتژیهای Chunking قطعهبندی میشوند.

- کاربرد اصلی: این مدل برای پاسخ به سوالات توصیفی و اطلاعاتی ایدهآل است. (مثلاً: «شرایط مرخصی استعلاجی طبق آخرین بخشنامه چیست؟» یا «برای استخدام چه مدارکی نیاز است؟»).

- مزایا و معایب: پیادهسازی این معماری سریع است و پوشش کاملی بر اسناد متنی دارد، اما در درک روابط پیچیده بین اشیاء و استدلالهای چندمرحلهای ضعف دارد.

2. دادههای ساختاریافته (Structured Data)

این معماری مخصوص دادههایی است که نظم ذاتی دارند و در قالب جداول، ستونها و رکوردهای دقیق تعریف شدهاند. منابعی مانند فایلهای Excel، CSV و دیتابیسهای رابطهای (SQL) که حاوی دادههای مالی، تراکنشی و عملیاتی هستند، خوراک این سیستماند.

- کاربرد اصلی: این معماری برای سوالات تحلیلی، آماری و عددی طراحی شده است. (مثلاً: «مجموع فروش شعبه غرب در سه ماه اول سال چقدر بود؟» یا «میانگین رضایت مشتریان نسبت به پارسال چه تغییری کرده است؟»).

- مزایا و معایب: بزرگترین مزیت آن دقت ۱۰۰ درصدی در محاسبات و قابلیت اجرای فیلترها و تجمیعهای پیچیده است. اما پاشنه آشیل آن، احتمال خطای مدل در تولید کد SQL معروف به (SQL Hallucination) است که میتواند منجر به نتایج غلط شود.

3. گراف دانش (Knowledge Graph)

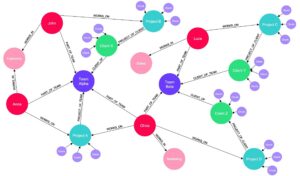

این پیشرفتهترین و بالغترین نوع معماری در سیستمهای RAG است. در گراف دانش، ما به جای ذخیره صرف اطلاعات، روابط بین آنها را ذخیره میکنیم. این ساختار از سهتاییهای «موجودیت ← رابطه ← موجودیت» تشکیل شده است (مانند: علی رضایی ← مدیریت میکند ← پروژه X.)

ساخت این پایگاه دانش نیازمند فرآیند دقیق استخراج موجودیت و رابطه است. دادهها در دیتابیسهای گرافی قدرتمند مثل Neo4j یا Amazon Neptune ذخیره میشوند. در زمان پرسش، مدل میتواند با پیمایش گراف، ارتباطات پنهان بین دادهها را کشف کند.

- کاربرد اصلی: این مدل برای سوالات استدلالی، چندمرحلهای و دارای وابستگی حیاتی است. (مثلاً: «کدام پروژههایی که آقای رضایی مدیریت میکند، با پروژههای تیم فنی تداخل زمانی دارند؟»). در این مثال، سیستم باید هم مدیر پروژه، هم تیم فنی و هم زمانبندیها را در ارتباط با هم درک کند.

- مزایا و معایب: گراف دانش با درک عمیق روابط، جلوی بسیاری از توهمات مدل در استدلال را میگیرد، اما هزینه ساخت بالا و نیاز به مهندسی دانش (Knowledge Engineering) پیچیده، از چالشهای اصلی آن است.

خط لوله داده پایگاه دانش چگونه ساخته میشود؟

ساخت یک پایگاه دانش کارآمد، فراتر از کپی کردن فایلهاست. این یک فرآیند مهندسی دقیق است که به آن ETL for AI میگویند. بیایید مراحل حیاتی این خط لوله را بررسی کنیم:

مرحله ۱: بارگذاری و پاکسازی (Ingestion)

اولین قدم، جمعآوری دادهها از منابع مختلف (PDF, Docx, Web, SQL) است.

- چالش واقعی: فرض کنید یک فایل PDF قرارداد دارید که در تمام صفحات آن «شماره صفحه» و «لوگوی شرکت تکرار شده است. اگر این نویزها حذف نشوند، هوش مصنوعی ممکن است در پاسخ نهایی بگوید: «طبق صفحه ۴ از ۱۰!»

- قانون طلایی: Garbage In, Garbage Out (ورودی نامناسب = خروجی نامناسب). پاکسازی دقیق دادهها برای کیفیت نهایی حیاتی است.

مرحله ۲: استراتژیهای قطعهبندی (Chunking Strategies)

شما نمیتوانید یک کتاب ۱۰۰ صفحهای را یکجا به مدل بدهید (به دلیل محدودیت Context Window). باید متن را به قطعات کوچکتر خرد کنید. اما چگونه؟

- Fixed-Size : روش ساده (مثلاً هر ۵۰۰ کاراکتر). مشکل: ممکن است جمله را ناقص قطع کند.

- Recursive : روش هوشمندتر؛ برش را روی نقاط منطقی مثل پاراگرافها یا پایان جملات انجام میدهد.

- Semantic : پیشرفتهترین روش؛ با درک معنی متن، دقیقاً در جایی که «موضوع بحث» تغییر میکند، برش میزند.

- Overlap : همیشه ۱۰ تا ۲۰ درصد همپوشانی بین تکهها در نظر گرفته میشود تا مفاهیم در مرز برشها گم نشوند.

مرحله ۳: برداریسازی و نقش متادیتا (Embedding & Metadata)

- در این مرحله، متنها توسط مدلهای Embedding به بردار (لیست اعداد اعشاری) تبدیل میشوند تا برای ماشین قابل فهم باشند.

نقش حیاتی متادیتا: فرض کنید کاربر میپرسد: «گزارش فروش ماه گذشته چطور بود؟»

- بدون متادیتا: سیستم در کل گزارشهای ۱۰ سال گذشته جستجو میکند و ممکن است به اشتباه گزارش سال ۹۸ را بازیابی کند.

- با متادیتا: شما همراه متن، اطلاعات جانبی را هم ذخیره میکنید:

{

"text": "فروش ما ۲۰٪ رشد داشت...",

"metadata": {

1404:"سال",

"مرداد": "ماه",

"مدیر فروش": "نویسنده",

"مدیران ": "سطح_دسترسی"

}

}

اکنون میتوانید قبل از جستجو فیلتر کنید: «فقط در اسناد ۱۴۰۴ جستجو کن». این کار دقت را به طرز چشمگیری افزایش میدهد.

مرحله ۴: ذخیرهسازی در Vector Database

دیتابیسهای رابطهای سنتی (SQL) برای جستجوی معنایی مناسب نیستند. ما به ابزارهایی تخصصی مثل Pinecone, Milvus یا Qdrant نیاز داریم که از الگوریتمهایی مانند HNSW برای جستجوی فوقسریع در میان میلیونها بردار استفاده میکنند.

مکانیزم بازیابی (Retrieval)

پس از آمادهسازی پایگاه دانش، وقتی سوالی پرسیده میشود، چه اتفاقی میافتد؟

۱. جستجوی معنایی

سیستم به دنبال مفهوم میگردد، نه صرفاً کلمات کلیدی.

- مثال: کاربر جستجو میکند “وام مسکن”. سیستم سندی که حاوی عبارت “تسهیلات خرید خانه” است را پیدا میکند، زیرا ارتباط معنایی آنها را درک میکند.

۲. جستجوی ترکیبی

گاهی اوقات جستجوی وکتور در مواجهه با کلمات خاص دچار خطا میشود.

- مثال: کاربر به دنبال قطعه فنی XJ-900 است. وکتور ممکن است قطعه XJ-800 را پیشنهاد دهد چون شباهت زیادی دارند.

- راه حل: استفاده از Hybrid Search که همزمان درک معنایی (Vector) و تطابق دقیق کلمات (Keyword Search) را ترکیب میکند تا دقیقترین پاسخ ممکن را ارائه دهد.

۳. فراتر از متن

گراف دانش (GraphRAG): این جدیدترین رویکرد در سیستمهای RAG است. وکتور دیتابیسها در درک “روابط پیچیده” ضعف دارند.

- مثال: “آیا پروژهای که علی مدیر آن است، با پروژه مریم تداخل زمانی دارد؟” گراف دانش این اطلاعات را به صورت شبکه ذخیره میکند: (علی) –مدیر است–> (پروژه آلفا).

ارزیابی عملکرد (RAG Evaluation)

ساخت سیستم آسان است، اما اطمینان از کیفیت خروجی چالشبرانگیز است. ما با استفاده از فریمورکهایی مثل RAGAS سه شاخص کلیدی را میسنجیم:

- : Context Precision آیا اسناد بازیابی شده واقعاً حاوی پاسخ مورد نیاز بودند؟

- : Faithfulness آیا پاسخ نهایی دقیقاً بر اساس اسناد بوده یا مدل دچار توهم (Hallucination) شده است؟

- Answer Relevance آیا پاسخ نهایی ارتباط مستقیمی با نیت و سوال کاربر دارد؟

نتیجهگیری

تمام چیزی که تا اینجا گفتیم از ساخت پایگاه دانش، چانکینگ و پاکسازی دادهها، تا بردارسازی، مدیریت متادیتا، جستجوی معنایی، Hybrid Search و حتی ارزیابی RAG در ظاهر یک معماری پیچیده و کاملاً فنی است.

اما نکته مهم اینجاست:

شما بدون حتی یک خط کدنویسی میتوانید تمام این فرایندها را در هوشیار انجام دهید.

در هوشیار نیازی نیست درگیر Vector Database، مدلهای Embedding، طراحی چانکینگ یا پیادهسازی Retrieval شوید.

فقط کافیست اسناد خود را بارگذاری کنید؛ هوشیار همه مراحل مهندسی داده، ایندکسگذاری و بازیابی را بهصورت خودکار انجام میدهد و یک پایگاه دانش حرفهای و آمادهبرای-RAG را برایتان میسازد.

اگر به دنبال ساخت یک سیستم هوش مصنوعی کاربردی، دقیق و سازمانی هستید، هوشیار مسیر را برایتان هموار کرده است.